12月8日,美团LongCat团队今日正式发布并开源其图像生成与编辑模型LongCat-Image。该模型参数规模为60亿(6B),官方称其旨在通过一套统一架构处理文本生成图像及自然语言指令编辑任务。

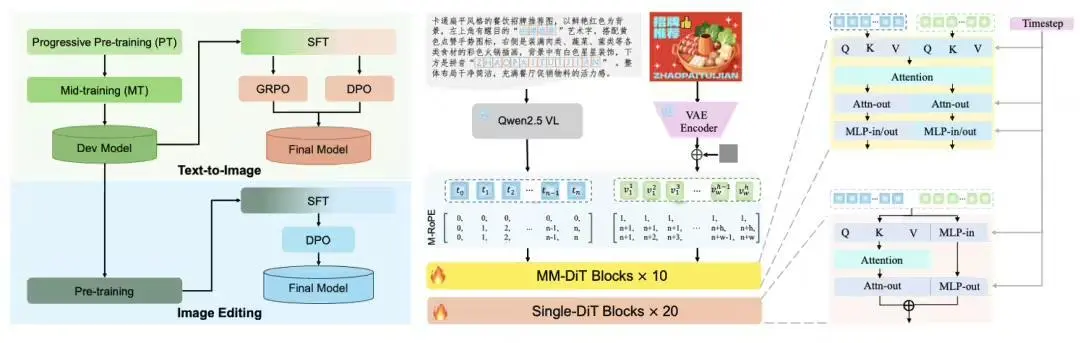

模型架构

根据官方介绍,LongCat-Image采用文生图与图像编辑同源的混合骨干架构(MM-DiT+Single-DiT),并整合了视觉语言模型(VLM)条件编码器。其主要技术特点包括:

1. 集成生成与编辑:模型支持通过文本提示生成图像,并可通过自然语言指令对图像进行多轮编辑。官方列举了包括对象添加/移除、风格迁移、背景替换、文本修改等在内的15类编辑任务,并宣称在多轮编辑中能保持图像风格、光照的一致性。

风格迁移与属性编辑能力对比

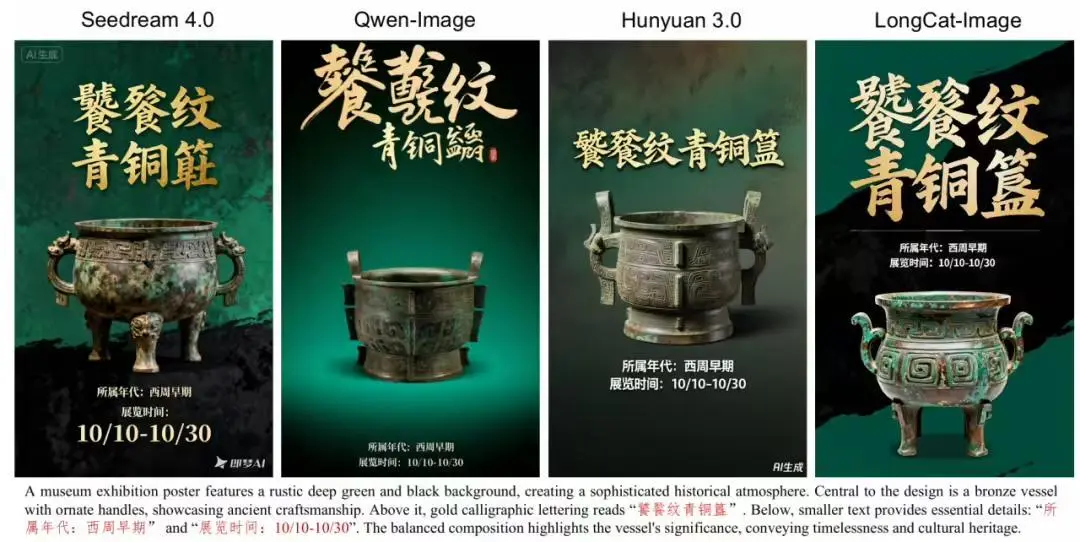

2. 中文文本渲染能力:模型强调对中文文本生成的支持,声称能够处理标准汉字、生僻字及部分书法字体,并可根据场景自动调整字体、大小和排版。技术实现上,模型通过预训练阶段学习字形,并在后续训练中引入真实世界文本图像数据以提升泛化能力。

文字生成能力对比

3. 输出效率与质量:通过模型结构轻量化与训练策略优化,宣称可在消费级GPU上实现高效推理,并生成具有“摄影棚级”细节的图像。

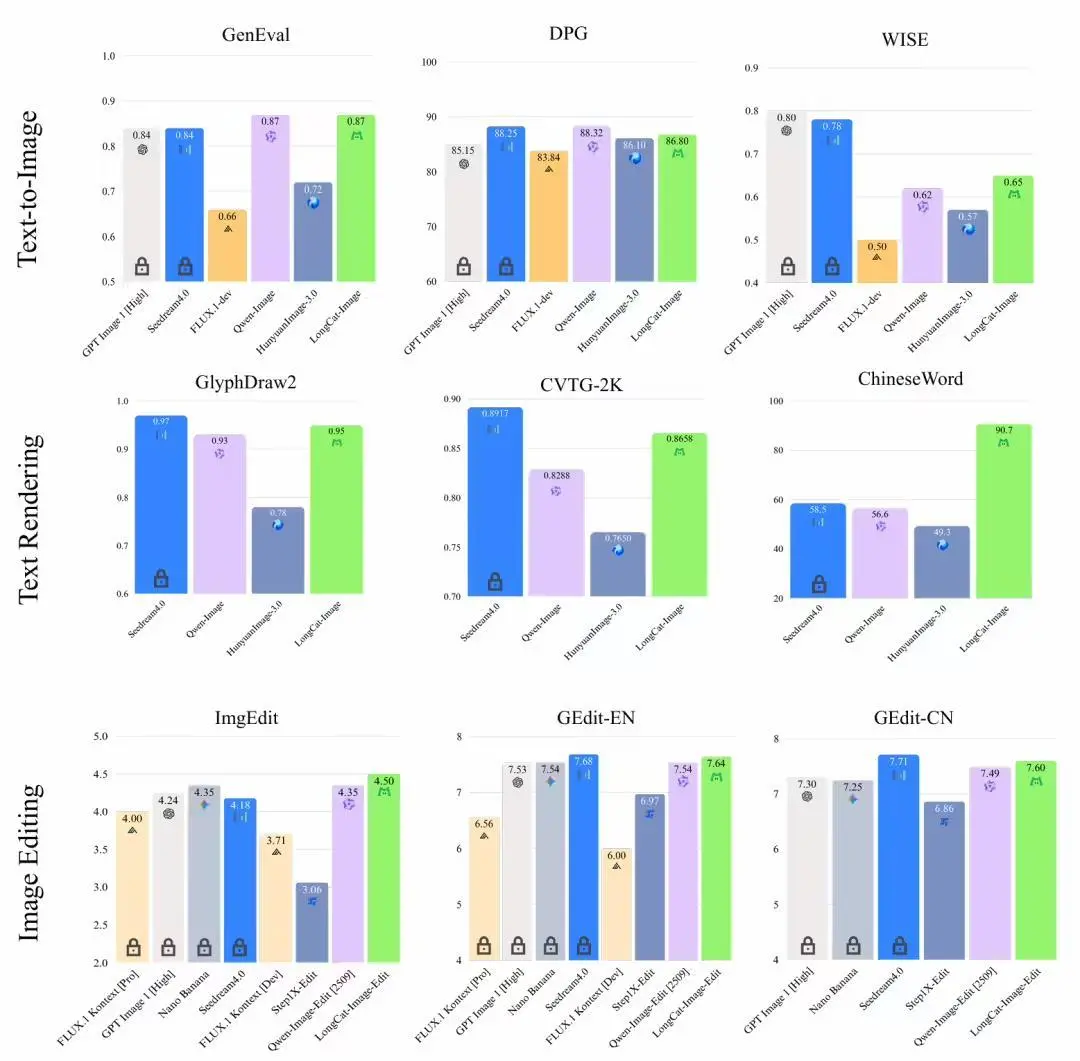

图像生成综合能力对比

在性能评估方面,官方提供了部分基准测试数据:

1. 在图像编辑基准测试GEdit-Bench和ImgEdit-Bench中,LongCat-Image得分分别为7.60/7.64(中英文)和4.50,均达到开源模型中的领先(SOTA)水平。

2. 在中文文本渲染专项评测ChineseWord中,得分为90.7分。

3. 在文生图基础能力测试GenEval和DPG-Bench中,得分分别为0.87和86.8。

目前,该模型已在GitHub平台开源,其功能可通过LongCat APP或网页端(longcat.ai)进行体验。官方表示,此次开源旨在支持从研究到商业应用的全流程,并邀请开发者参与共建。

此次开源动作显示出美团在AIGC领域,特别是针对中文市场及复杂图像编辑需求的技术布局。开源策略有助于其吸引开发者生态,并在快速发展的图像生成领域建立影响力。

【来源:凤凰网科技】