当前AI领域大模型技术飞速迭代,全球已发布数千个大模型,其中我国大模型数量突破 1500个;与此同时,AI算力芯片、服务器型号也层出不穷、快速迭代。“海量模型+多样硬件”的双重叠加,让企业陷入选型困境:该选哪款模型适配业务?配置何种硬件才够用?选型是否匹配实际需求?试错成本高、匹配度难把控,成为企业落地AI的“前置拦路虎”。

要破解这一难题,科学系统的模型评估是不可或缺的前置环节。浪潮云海InCloud AIOS构建全流程自动化、可视化模型评估体系,覆盖“评估规划-工具支撑-规划预测”全链路,既解决已部署模型的精准评估问题,也能满足智能云建设规划阶段的算力适配需求,让企业模型选型从盲目试错变为科学决策。

模型评估:四步构建科学评估闭环,避免选型偏差

一套完整的模型评估体系通常包括性能评估和质量评估两个维度。性能评估关注大模型的生成效率,如响应速度、吞吐量等;质量评估则侧重生成内容的相关性、准确性和实用性。

第一步:明确目标与指标制定

评估的核心前提是目标清晰。模型性能指标通常包括首token延迟(TTFT)、token间延迟(TBT)、吞吐量(TPS)和请求处理能力(RPM)等;质量指标则涵盖准确率、精确率、召回率等客观指标,以及相关性、流畅性、有用性、安全性等主观指标。企业需要根据自身业务场景特点,如客服、内容创作等具体需求,制定针对性的评估指标体系。

第二步:数据集准备与环境构建

高质量的数据集是评估可靠性的基础。数据集主要包括公开基准数据集和业务私有数据集两大类。公开数据集如MMLU、C-Eval、GSM8K等权威基准测试集,主要用于评估模型的通用能力;而业务私有数据集则更为关键,需要精心准备能够代表实际业务场景的高质量测试集。同时,需要构建稳定的测试或者对比测试环境,确保模型能够正常部署和访问。

第三步:测试执行与结果收集

选择合适的测试工具并执行测试是核心环节,重点确保过程“高效、一致、可复现”。评估工具需要能够自动化执行测试用例,并完整保存测试记录,为后续分析提供数据基础。其中,质量评估往往需要对输出内容进行人工打分或自动评分,以形成后续综合评估报告。

第四步:结果分析与综合评估

本阶段将原始数据转化为有价值的洞察,通常包括定量分析和定性分析。定量分析通过具体数值对比模型表现,定性分析则深入探究模型输出的质量和适用性。结果通常通过雷达图、柱状图等可视化形式呈现,便于直观比较和综合权衡。

模型评测套件:一键完成全维度“体检”,低门槛上手

针对企业评估技术门槛高、流程繁琐的痛点,浪潮云海InCloud AIOS提供模型评估全流程的自动化、可视化工具集。平台支持内置丰富的通用评测集,同时支持自定义评测集的上传、存储和查询等全生命周期管理。通过上下文智能生成、多并发负载模拟、全维度指标采集和实时评测可视化等技术,实现模型服务的一键量化评估,引入专家标注和裁判大模型自动打分等多种评估机制,即使没有专业技术人员,企业也能自主完成全面的模型评估。

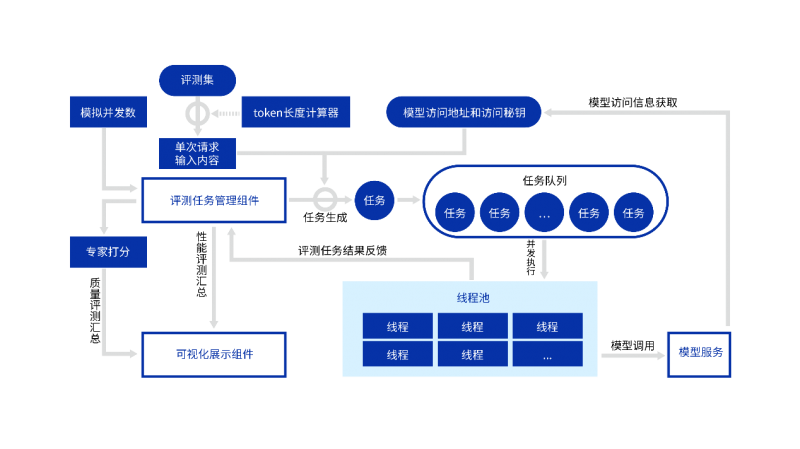

自动化测评工具的核心技术流程涵盖任务编排、并发执行、数据采集与可视化汇总四个关键阶段,其系统化运作机制如下:

* 测评任务生成与队列化:系统根据预设的并发数、评测集、输入/输出长度以及模型服务访问地址等信息,自动生成对应的测评任务,并将其加入调度任务队列中。为避免因缓存命中导致的性能测试失真,采用随机化数据集测试方法,从而能够更加真实的反映高并发、随机性场景下的性能。

* 高并发模拟与模型调用:通过动态线程池技术,系统根据并发数配置生成相应数量的线程,模拟多用户并发请求。每个线程从任务队列中获取任务后,分别对目标模型服务进行压测,并实时采集关键性能指标 。

* 性能指标采集与反馈:任务执行过程中,系统记录包括首token延迟、token间延迟、每秒token数等核心性能指标。这些数据实时反馈至评测任务管理组件,支持按指定评测时长或任务数量进行多轮迭代测试,最终对所有任务的评测结果进行百分位数统计,形成量化性能视图。

* 可视化综合呈现:在质量评估环节,系统结合可视化专家打分流程,实现对生成内容质量的精准评估。最终,通过可视化展示组件将性能与质量两方面的数据(包括图表、分数、趋势等)进行整合,生成直观的仪表盘或综合评测报告,为模型优化或部署决策提供数据支撑。

性能规格双向预测,算力规划得心应手

在线的模型评测往往反应了模型的真实水平,但是依赖于已经部署到模型实例,在智能云建设规划时期往往无法具备条件。浪潮云海InCloud AIOS创新性地设计了模型性能评估工具,为大模型推理过程建立性能模型并通过分析大模型运行全流程的资源消耗,综合硬件算力(FLOPs)、模型计算量(FLOPs/token)和系统效率等因素,实现模型性能和硬件配置间的双向预测,当输入某一模型和硬件后,能够预测该组合下吞吐量、延迟和并发处理能力等关键性能指标,当给定模型和业务性能诉求后,能够精准推荐算力、显存等硬件配置,误差偏差在30%以内。

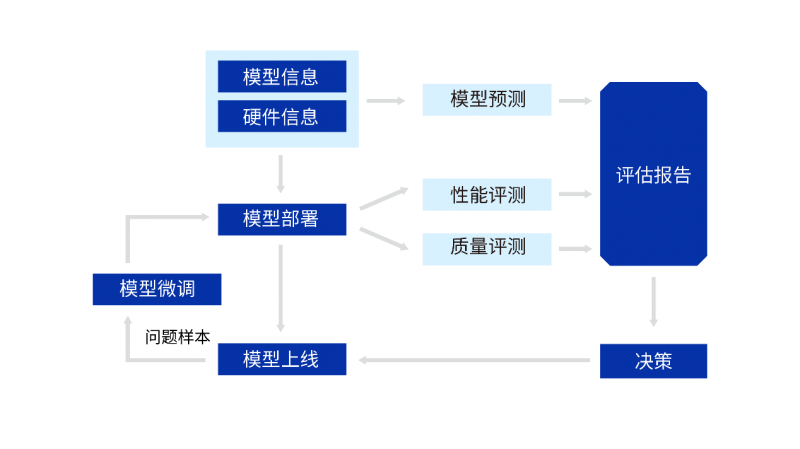

向全流程智能化演进,让模型选型游刃有余

未来,随着大模型技术的持续演进,模型评估体系将从“工具集合”进一步升级为融合测试、分析与功能优化的智能系统,通过线上反馈、模型微调、自动化测试、性能瓶颈分析、模型发布部署等环节的紧密衔接,最终形成模型自动演进的完整闭环,为企业提供更加智能、高效的模型选型和优化解决方案。

从当下的科学选型到未来的智能演进,浪潮云海InCloud AIOS 始终以专业评估能力为企业AI落地保驾护航,让每一次模型决策都心中有数,让企业在AI落地浪潮中游刃有余。