2026年元旦伊始,中国旅游市场呈现量价两旺的开门红。“00后”和“90后”出游占比达到72%,成为绝对主力军。与曾经的标准模板参团游相比,年轻群体不再满足于传统的观光游览,更加注重旅行体验和个性化表达,他们开始通过各种旅行助手AI工具定制、设计“千人千面”的主题行程。而AI工具需求的快速放大,成为了重塑文旅市场服务模式的“发动机”,也对背后的云计算底座提出了新的要求。

承接元旦出行的旺盛需求,同程旅行以DeepTrip智能旅行助手为关键抓手,推动服务智能化进一步升级。在搭载了腾讯云计算加速套件TACO后,同程旅行GPU利用率从40%提升到80%以上,模型推理速度同步获得优化,为旅游行业AI大规模应用提供了可复制、可参考的成功范例。

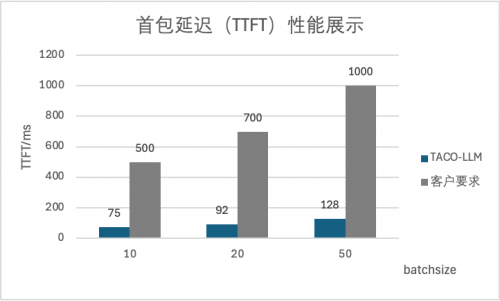

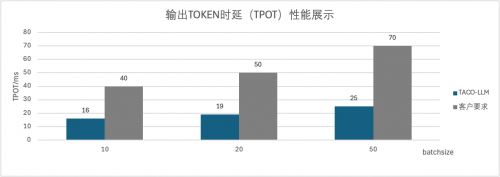

在同程的业务场景中测试,同样的测试条件下,TACO推理的性能表现,在满足业务精度要求下,首包延迟缩短到原来的15%,输出Token时延缩短为原来的40%。

(延迟指标越低越好)

(延迟指标越低越好)

同程旅行DeepTrip智能旅行助手自3月上线以来,承载着同程旅行从“工具型”平台向“智能服务型”平台转型的战略重任。该智能体需要理解用户自然语言描述的旅行需求,实时生成个性化行程建议,并整合酒店、交通、景点等资源。作为国内领先的在线旅行服务平台,同程旅行每日需处理数百万次用户查询,尤其在国庆、元旦等高峰时段,并发请求量急剧增长,DeepTrip面临稳定运行、快速响应等挑战。

在此背景下,同程旅行选择与腾讯云进行深度合作,部署大模型推理服务。并搭配TACO加速能力,优化吞吐。其中在DeepSeek模型部署场景中,推理服务吞吐提升两倍,显著降低成本,提升业务体验。

腾讯云计算加速套件TACO立足于腾讯丰富的AI业务场景,专注于生成式AI的核心技术优化,包括训练框架优化、推理性能优化,为客户提供涵盖文生文、文生图、文生视频等多个跨模态领域的AI加速能力。

其中TACO-LLM作为其核心组件,在大语言模型推理场景展现出显著优势,在GPU和国产硬件上,提供文生文场景兼顾高吞吐和低时延的优化方案。

具体而言,TACO-LLM支持公有化、私有化部署,部署简洁,开箱即用,全面兼容主流模型,包含DeepSeek和Qwen全系列,100%兼容开源引擎(vLLM),支持无缝迁移。

同时,基于TACO自研的加速组件TurboAttention、Lookahead Cache等,持续为客户优化推理性能。 并且支持大语言模型PD分离部署,吞吐可相较于开源版本提升2倍及以上,在多模态生成,多模态理解等场景,TACO均可提供50%+的加速。

实际应用显示,面向文生文和图文理解场景,TACO均能够提供加速能力,在DeepSeek R1满血版模型部署时,可实现吞吐性能提升2倍,首包延迟显著缩短12.5倍;在QwenVL、InternVL等模型部署中,计算能力提升超50%。在保障用户体验的前提下,可成功将业务推理资源消耗量降低至原来的一半,大幅度节约成本。

同程旅行与腾讯云的这一合作成果,不仅为同程旅行带来了显著的业务价值,也正推动整个行业向着更智能化方向持续发展,TACO将继续在更多行业场景中发挥价值,为各行各业的AI规模化应用提供了高效、可靠的实施路径。