近日,第63届国际计算语言学年会ACL 2025(Annual Meeting of the Association for Computational Linguistics,简称ACL)论文接收结果正式公布。云知声在此次国际学术盛会中表现卓越,共有4篇论文被接收,其中包括2篇主会论文(Main Paper)和2篇Findings。入选的4篇论文聚焦大语言模型知识溯源、图文音多模态大模型、大语言模型可解释性等关键领域,提出的创新理论和方法,为行业研究提供了新的思路。

ACL是自然语言处理领域最具影响力的国际会议之一,也是中国计算机学会(CCF)推荐的A类国际学术会议。该会议每年举办一次,由国际计算语言学协会主办。本届会议将于2025年7月27日至8月1日在奥地利维也纳举行。据统计,今年ACL总投稿数高达8000多篇,创历史之最,被称为ACL论文收录竞争最为激烈的一年。

云知声自2012年成立以来,在自然语言处理领域持续深耕,成果斐然。2017年Transformer及2018年BERT等深度学习模型的发布,推动了AI自然语言处理的重大突破。凭借自身在交互式AI方面的强大研发实力,云知声迅速推出首个基于BERT的大语言模型UniCore,作为云知大脑的初始核心算法模型,为后续一系列AI解决方案在广泛垂直行业的落地应用奠定了坚实基础。2023年,在自建的Atlas智算平台和多年积累的海量数据支持下,云知声推出了拥有千亿参数的大语言模型——山海大模型,并持续对其进行迭代升级。山海大模型不仅具备语言生成、知识问答、逻辑推理等十大核心能力,还在多模态技术方面不断实现突破,持续拓展文生图、音图问答等前沿功能,极大地丰富了用户交互体验。

在技术攻坚过程中,云知声收获了多项与自然语言处理相关的专利。例如,多语言摘要的生成方法、知识增强的非自回归神经机器翻译方法等,为多场景应用提供了有力支撑。在学术研究与行业认可方面,云知声持续输出优质成果,曾在CVPR 2024、INTERSPEECH 2023、ACM MM 2023等顶会发表多篇学术著作,并斩获CVPR2024开放环境情感行为分析竞赛三项季军。此次再度登顶国际学术舞台,充分印证了云知声在AI领域的技术创新实力,也将进一步夯实其AGI技术底座。

以下为入选论文概览:

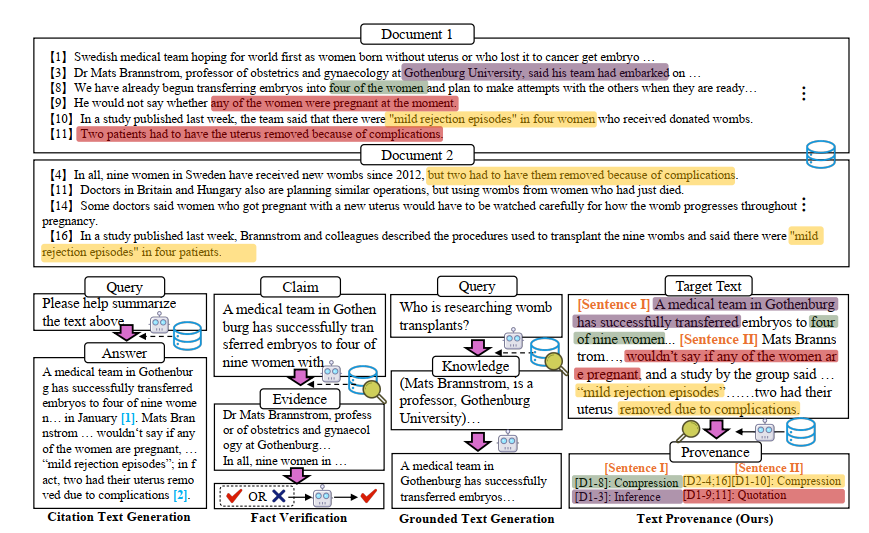

研究方向:大语言模型知识溯源

标题:TROVE: A Challenge for Fine-Grained Text Provenance via Source Sentence Tracing and Relationship Classification

作者:Junnan Zhu, Min Xiao, Yining Wang, Feifei Zhai, Yu Zhou,Chengqing Zong

论文简介:大语言模型在文本生成中的流利性和连贯性方面已取得了显著的进展,然而其广泛应用引发了对内容可靠性和责任心的担忧。在医疗、法律和新闻等领域,幻觉容忍度极低,了解内容的来源及其创作方式至关重要。为解决这一问题,我们推出了文本溯源任务(TROVE),旨在将目标文本的每一句话追溯到可能冗长或多文档输入中的特定源句子。除了识别来源,TROVE还标注细粒度的关系(引用、压缩、推断等),提供了每个大模型生成结果的细粒度分析。为TROVE任务建立基准,我们通过利用三个公开数据集构建了我们的数据集,涵盖了11种不同场景(例如问答和总结),包括英文和中文,且来源文本长度各异(0–5k,5–10k,10k+),并强化了对于溯源任务至关重要的多文档和长文档设置。为保证数据的高质量,我们设计了三阶段的注释过程:句子检索、GPT溯源及人工溯源。我们在提示工程和检索增强模式下评估了11个大语言模型,结果显示检索对于鲁棒性至关重要,较大的模型和闭源在各类任务中表现更佳,但在检索增强的场景下,开源模型显示出显著优势。

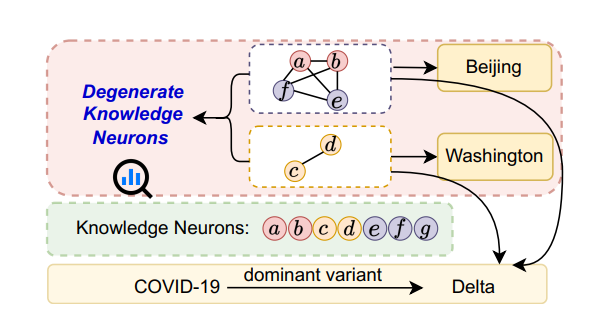

研究方向:大语言模型的可解释性

标题:Cracking Factual Knowledge: A Comprehensive Analysis of Degenerate Knowledge Neurons in Large Language Models

作者:Yuheng Chen, Pengfei Cao, Yubo Chen, Yining Wang, Shengping Liu, Kang Liu, Jun Zhao

论文简介:知识神经元理论提供了一种理解大型语言模型(LLMs)中事实性知识机制的重要方法,该理论表明,事实性知识存储在多层感知器神经元中。本文进一步探索了简并知识神经元(DKNs),即不同的神经元集合可以存储相同的事实,但与简单的冗余机制不同,它们还参与存储其他不同的事实性知识。尽管这一概念具有新颖性和独特性,但尚未得到严谨定义和系统研究。我们的贡献包括:(1)我们通过分析权重连接模式,开创了对知识神经元结构的研究,从功能和结构两个方面提供了DKNs的全面定义。(2)基于此定义,我们设计了神经拓扑聚类方法,从而更准确地识别DKNs。(3)我们展示了DKNs在两个方面的实际应用:引导大语言模型学习新知识以及增强大语言模型在输入错误时的鲁棒性。

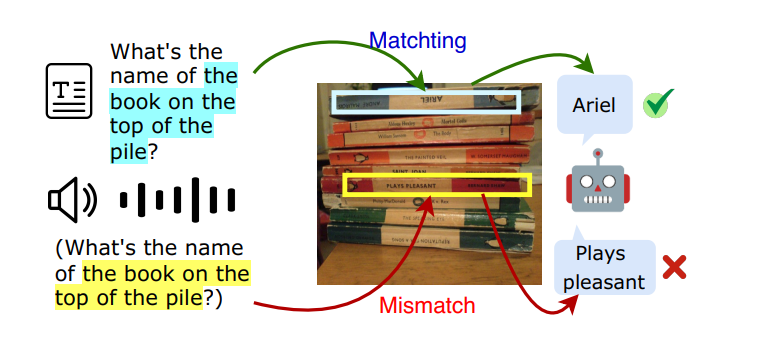

研究方向:图文音多模态大模型

标题:Investigating and Enhancing Vision-Audio Capability in Omni Modal Large Language Models

作者:Rui Hu, Delai Qiu, Shuyu Wei, Jiaming Zhang,Yining Wang, Shengpeng Liu, Jitao Sang

论文简介:全模态大语言模型(OLLMs)在整合视觉和文本方面取得了显著进展,但在整合视觉和音频方面仍然存在困难。具体来说,与处理文本查询相比,模型在处理音频查询时通常表现不佳。这种差异主要是由于在训练过程中视觉和音频模态之间的对齐不足,导致在使用音频查询时对视觉信息的关注不够。为了解决这一问题,我们提出了一种自知识蒸馏(Self-KD)的训练方法,其中以OLLM的视觉-文本组件作为教师模型,视觉-音频组件作为学生模型。这使得模型能够学习以类似于处理文本查询的方式处理音频查询。实验结果表明,Self-KD可以有效提升全模态语言模型视觉-音频能力,其通过从视觉-文本组件中学习,进而改善音频与图像之间的交互,并最终提升多模态任务的性能。

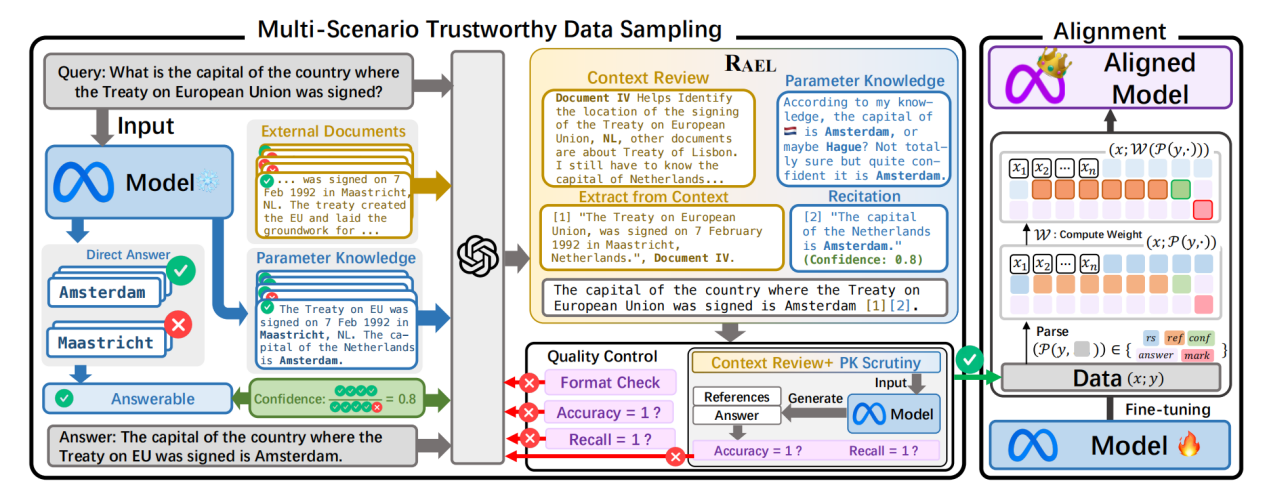

研究方向:大语言模型检索增强

标题:Transparentize the Internal and External Knowledge Utilization in LLMs with Trustworthy Citation

作者:Jiajun Shen, Tong Zhou, Yubo Chen, Delai Qiu, Shengping Liu, Kang Liu, Jun Zhao

论文简介:检索增强生成和引文生成技术可以缓解大语言模型的幻觉问题,但模型调用内部知识的机制仍不透明,其生成答案的可信度依然难以保证。为此,我们提出“基于上下文-先验的引用生成”任务,要求模型在综合外部知识和内部知识的基础上生成可信的引用。

我们的主要贡献包括:

1. 提出了“上下文-先验的引用生成”任务,要求模型能够根据先验知识合理引用参考文献,并制定了5项评价指标,包括(1)答案有效性准确率,(2)真实引用召回率,(3)论证说服力,(4)表述简洁度,(5)衡量参考文献可信度的预期校准误差;从答案有效性、引用准确性和结果可信度三个维度全面评估模型表现。

2. 开发了RAEL框架,要求模型审阅自我生成的相关概念或先验知识,实现对上下文的准确引述;INTRALIGN方法,通过多场景可信数据生成和可解释性对齐,使模型能够有效利用先验知识输出更可靠的回答。

3. 在4种不同场景下测试了3类大语言模型和6种基线方法。结果表明,现有方法难以全面提升任务效果,而我们的方案不仅能准确引用参数化的内部知识,还能显著提高引用质量和回答的可信度。

以上四篇论文的入选,是对云知声坚持技术创新、推动产学研深度融合的有力肯定。未来,云知声将继续秉持开拓精神,深耕人工智能技术,不断探索和拓展大模型的应用边界,为全球科技进步贡献更多中国智慧和创新力量。