1 月 15 日消息,月之暗面今日发布了 Kimi 多模态图片理解模型 API,全新多模态图片理解模型 moonshot-v1-vision-preview(以下简称“Vision 模型”)完善了 moonshot-v1 模型系列的多模态能力。

模型能力说明

图像识别

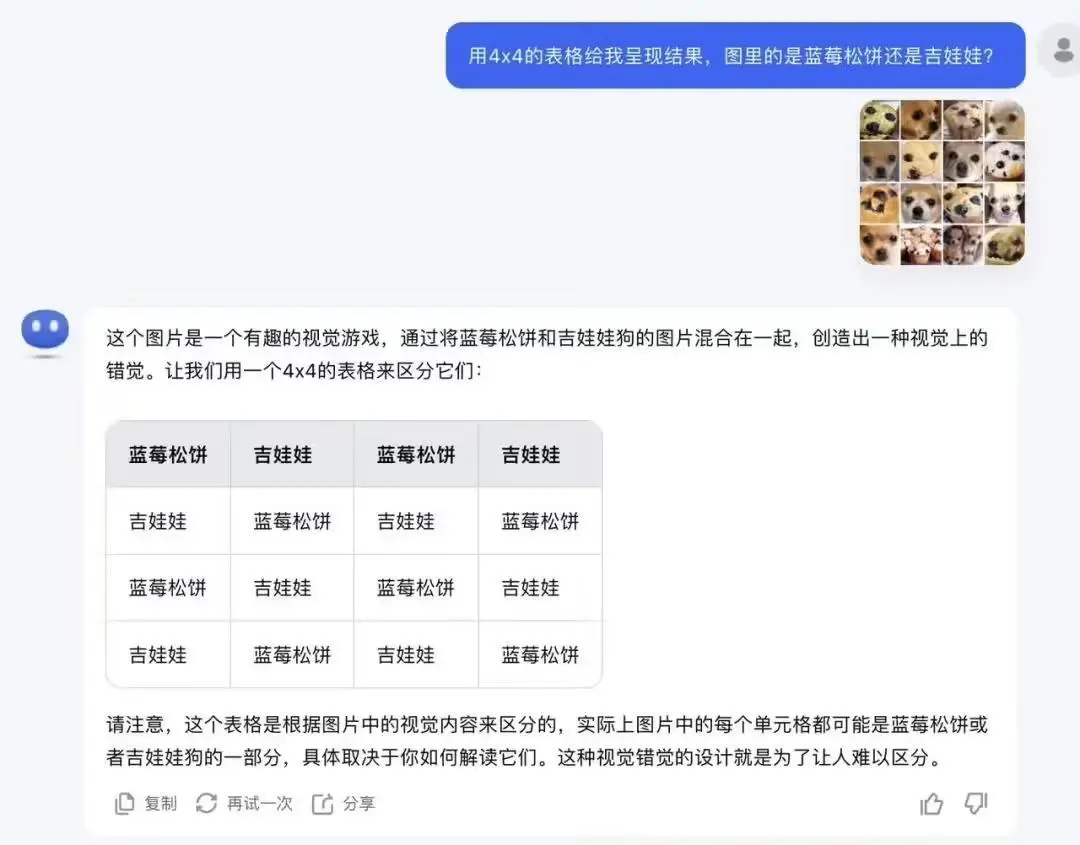

Vision 模型具备图像识别能力,能够识别出图像中的复杂细节和细微的差别,无论是食物还是动物,能够区分出相似但又不相同的对象。

下图示例中,官方拼凑了 16 张相似的人眼较难区分的蓝莓松饼和吉娃娃图片,由 Vision 模型来识别并按顺序标记图片类型,无论是蓝莓松饼还是吉娃娃,模型都能精确地区分和识别。

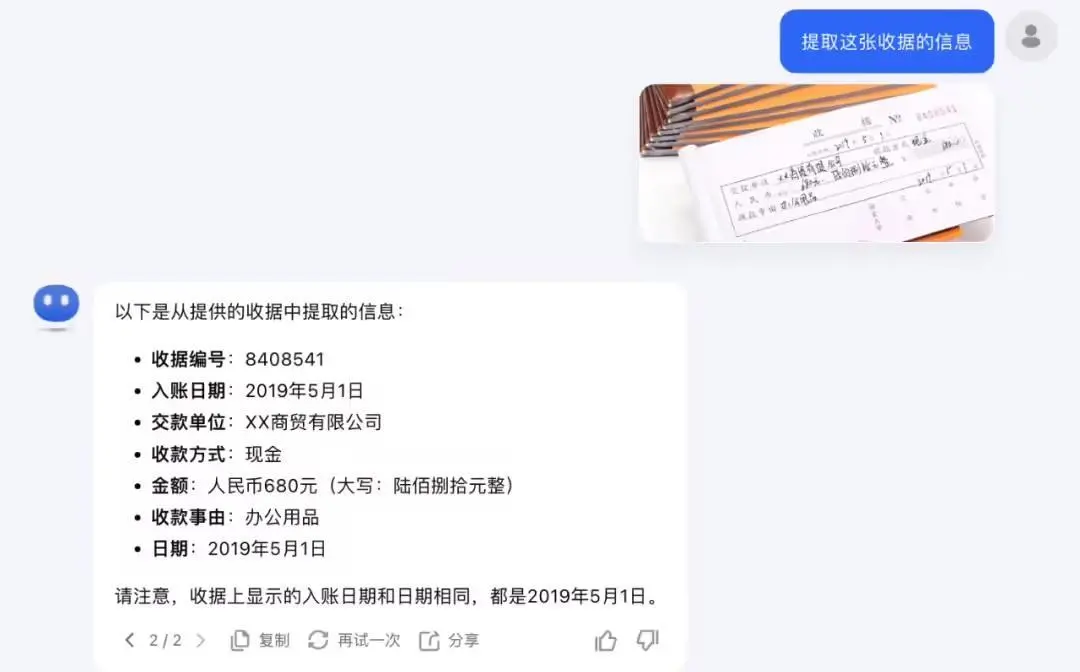

文字识别和理解

Vision 模型具备高级图像识别能力,在 OCR 文字识别和图像理解场景中,比普通的文件扫描和 OCR 识别软件更加准确,例如收据单 / 快递单等潦草的手写内容都可以准确识别。

以这张《某学生期末考试成绩》柱状图为例,官方让模型提取分析考试成绩,并从美学风格的角度分析一下该柱状图。Vision 模型也能够精准地识别出柱状图中每个科目名称对应的分数数值并做分数对比,同时可以识别出该柱状图的样式格式和颜色等。

模型计费

Vision 模型实行按量计费方式,单张图片按 1024 tokens 合并计算在 Input 请求的 tokens 用量中,模型调用的价格根据选择的模型而不同,IT之家附具体区分如下:

模型计费单位价格moonshot-v1-8k-vision-preview1M tokens¥12.00moonshot-v1-32k-vision-preview1M tokens¥24.00moonshot-v1-128k-vision-preview1M tokens¥60.00

模型限制说明

Vision 视觉模型支持的特性包括:

多轮对话

流式输出

工具调用

JSON Mode

Partial Mode

以下功能暂未支持或部分支持:

联网搜索:不支持

Context Caching:不支持创建带有图片内容的 Context Cache,但支持使用已经创建成功的 Cache 调用 Vision 模型

URL 格式的图片:不支持,目前仅支持使用 base64 编码的图片内容

其他平台更新

支持组织项目管理功能

支持一个企业实体认证多账号

增加 File 文件资源管理功能:直观管理查看文件资源

优化资源管理列表鼠标悬浮复制

Context Caching 功能已放开给全量用户

Cache 续期不再收取创建的费用

【来源:IT之家】